こんにちは,研究開発室の福井です.研究開発室においてオペレーションズ・リサーチ(OR)のビジネス活用について研究を行っております.今回は,OR の技術を用いて何らかの計画を作成する際に,「出力された計画が何故そうなったのか?」を説明するための方法や関連した既存研究を紹介します.

AI における説明可能性の必要性

近年,AI 技術の進展により,さまざまな分野で AI が活用されています.しかし,AI が出力する結果や意思決定のプロセスがブラックボックス化していることが課題として挙げられています.このような状況では,AI の結果に対する信頼性や透明性が欠如し,特に以下のような場面で問題が生じる可能性があります.

意思決定の正当性の確認: 医療や金融などの分野では,AI が出した結果がどのように導かれたのかを説明できることが重要です.これにより,結果の正当性を確認し,必要に応じて修正を加えることが可能になります.

ユーザーの信頼獲得: AI を利用するユーザーがその結果を信頼するためには,結果の根拠を理解できることが必要です.説明可能性があることで,ユーザーは AI の判断を納得しやすくなります.

規制や倫理的要件への対応: 一部の業界では,AI の意思決定プロセスを説明することが法的または倫理的に求められる場合があります.説明可能性は,これらの要件を満たすための重要な要素です.

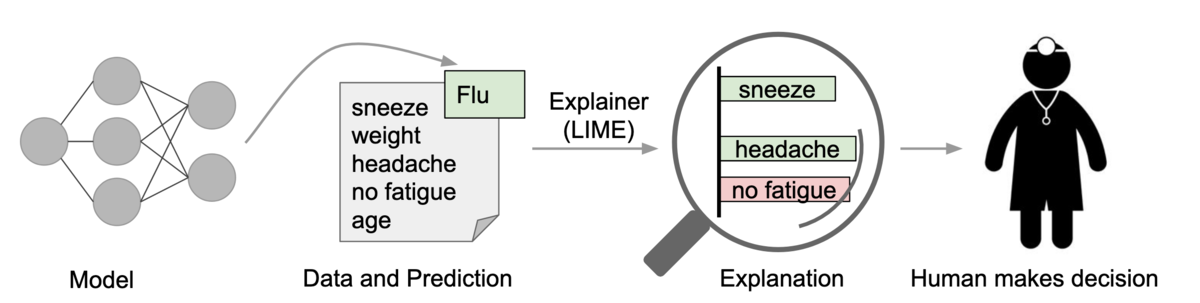

このように,AI における説明可能性は,技術の信頼性を高め,社会的受容性を向上させるために欠かせない要素となっています.特に,入力と出力との対応関係が非自明になりやすい機械学習(ML)のモデルにおいてこの観点は非常に重要であり,説明可能性のための研究が盛んに行われています.ML モデルの出力を説明するための代表的な手法には LIME (Riberio et al., 2016) や SHAP (Lundberg & Lee, 2017) などがあります.これらの技術を用いると,モデル出力結果に対してどの入力データ(特徴量)が大きく寄与しているかを定量的に評価することができ(図 1),近年ではこれらの手法をすぐに試せる便利なパッケージも提供されています.

一方,OR の(特に計画を作成するよう問題の)場合はどうでしょうか? 数理最適化の技術を用いて計画を作成するにはまず,実課題を線形計画問題(LP)や混合整数計画問題(MIP)などに落とし込みます(船舶の配線計画をモデリングした例). このとき,実課題のどの要素がどのように数理モデルに反映されるかは,問題を解く人間が意図的に決定します.計画の KPI や計画が守るべきルールも全て人手によってモデル上に明記されます*1.そのため,数理最適化の結果は,入力データ(数理モデルのパラメータ)と出力結果(計画)との対応関係が明確であり,ML モデルで使われるような説明の技術が不要なように感じられるかもしれません.では,OR において説明が必要になるのはどのような場面であり,どのような種類の説明が必要となるのでしょうか?

OR において説明が必要な場面

OR の専門家や最適化エンジニアの人々にとっては,先に述べたように数理モデルの入力と出力の関係はほぼ自明に見えるかもしれません.しかし,数理最適化の結果を利用するビジネスユーザにとっては,数理モデルの入力と出力の関係は必ずしも明確ではありません.そのため,数理最適化の結果をユーザに説明する必要が生じます.

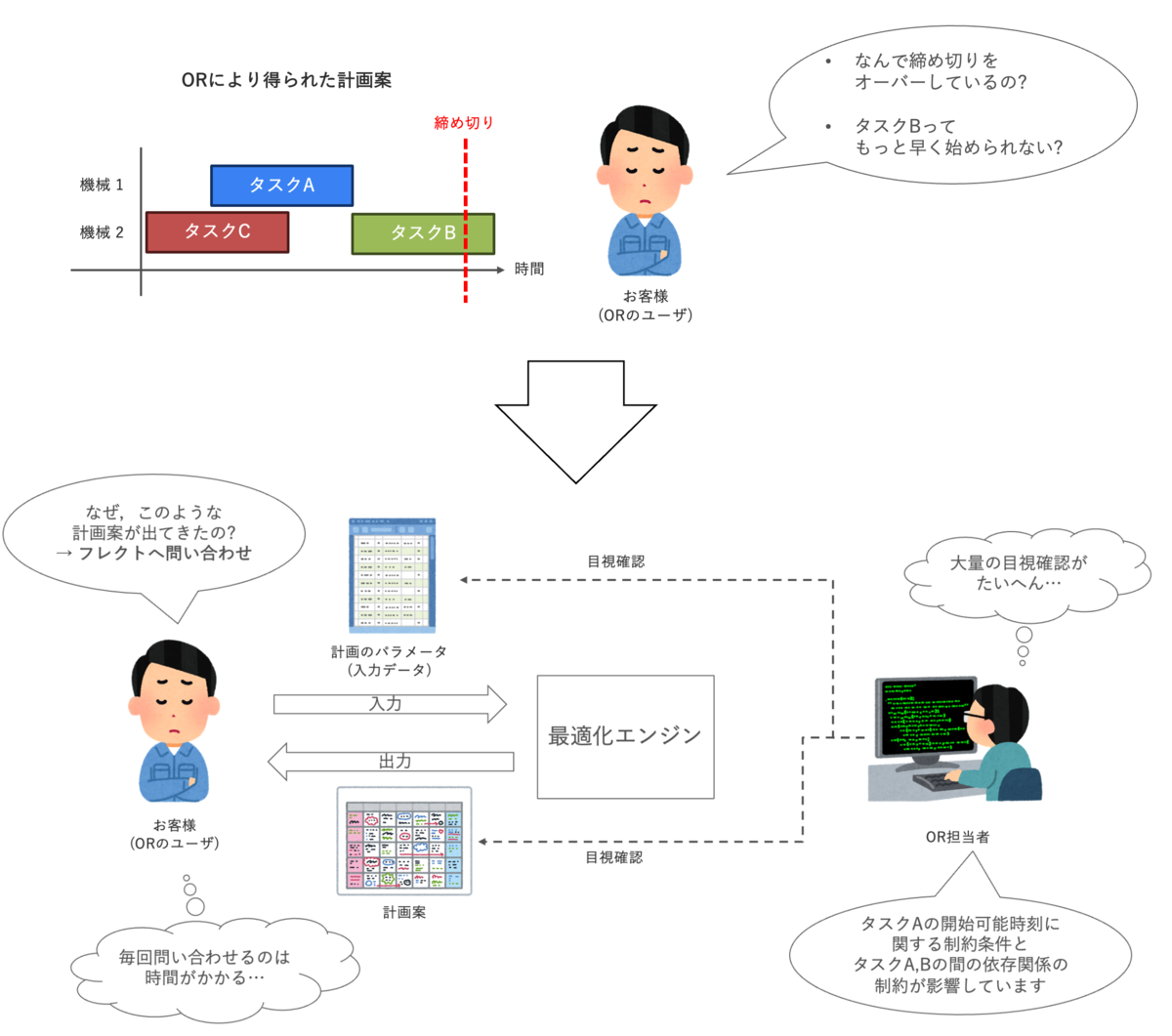

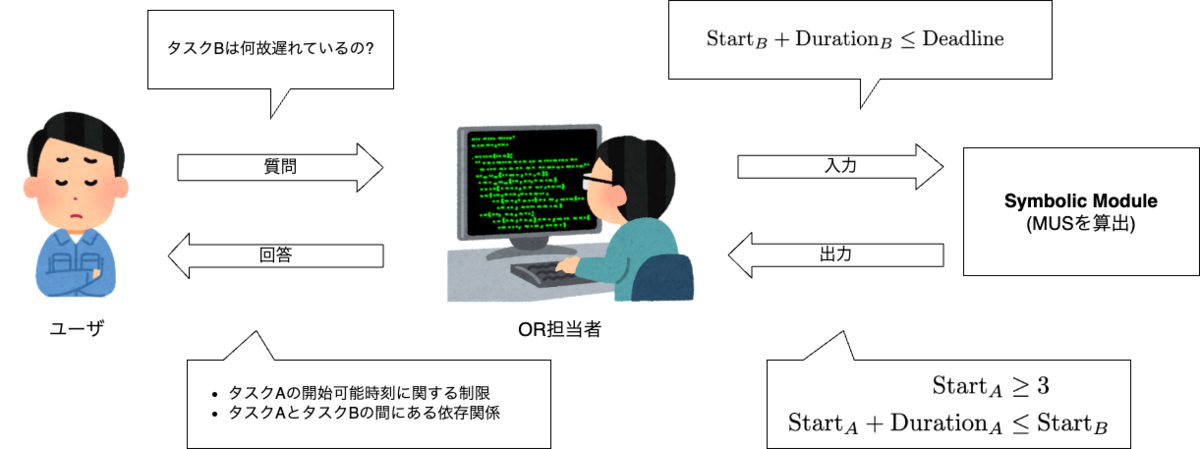

具体的には図 2 のような場面が OR システムの PoC や導入後の運用において度々発生します*2.この図において,ユーザは OR により得られた製造計画を確認しています.複数あるタスクの内のひとつが締め切りから遅れていることに気が付きました.この時,ユーザは「なぜこのタスクは締め切りに間に合わないのか?」という疑問を持ちます.そして,その原因を特定できない場合,裏で何が起きているのかを OR の専門家に問い合わせることとなります.次に,問い合わせを受けた OR の専門家は数理モデル,入力されたデータ,出力された計画を確認することで,何が影響して今現在の計画案になったかを調べます.これだと,ユーザが結果に対して疑問を抱くたびに専門家に問い合わせることとなり,ユーザ体験が損なわれてしまいます.また,問い合わせに対応する専門家にとってもこの作業は負担が大きく,可能ならば省力化できるのが望ましいです.

このように,OR においても説明が必要な場面が存在することがわかりました.では,先の例をはじめとしたORの解に対する様々な説明を自動で行うために私達は具体的に何をすれば良いのか?という疑問が生じます.今日までの研究において様々な説明のアプローチが提案されています.次節ではこれらのアプローチをいくつか紹介します.

既存研究における説明のアプローチ

先述のとおり,OR において必要となる説明は ML のそれとは異なっています.皆様は,「そもそも,OR における説明とは何か?」という点に疑問を持たれるかもしれません.既存研究において「説明」として提案されている手法には様々なものがあります.本節では,それらを(筆者の主観混じりで)大きく 4 つに分類し,それぞれの説明のアプローチを簡単に紹介します.

- What-if 分析/感度分析

- Contrastive explanations

- Counterfactual explanations

- Argumentative explanations

What-if 分析/感度分析

数理最適化における What-if 分析や感度分析は,入力データや制約条件を少し変更した場合に最適解や目的関数の値がどのように変化するかを調べる手法です.これにより,「もしこのパラメータが変わったら計画はどうなるか?」や「どの制約が結果に強く影響しているか?」といった疑問に答えることができます.例えば,製造計画の最適化問題では,原材料の供給量や納期,設備の稼働時間などのパラメータを変更し,その影響を確認することで,計画の柔軟性やボトルネックを把握できます.他にも「原材料 A の入荷が 1 日遅れた場合,どの製品の納期に影響が出るか?」「設備 B の稼働時間を 2 時間増やすと全体の生産量はどれだけ増えるか?」といったシナリオを検証することもできます.これらの手法は古くから存在しており,あまり「説明」という印象を受けないかもしれませんが,計算結果を解釈するために非常に有用な情報をユーザに提供してくれます.

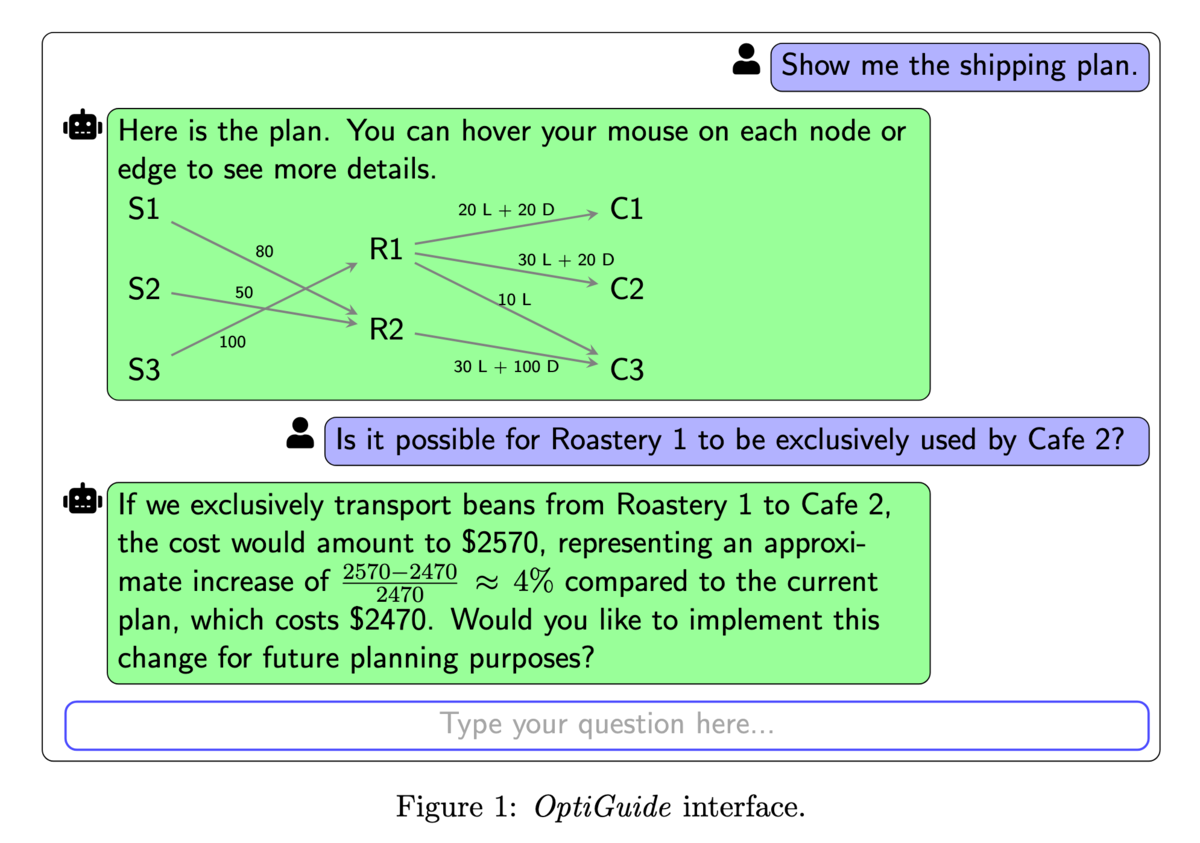

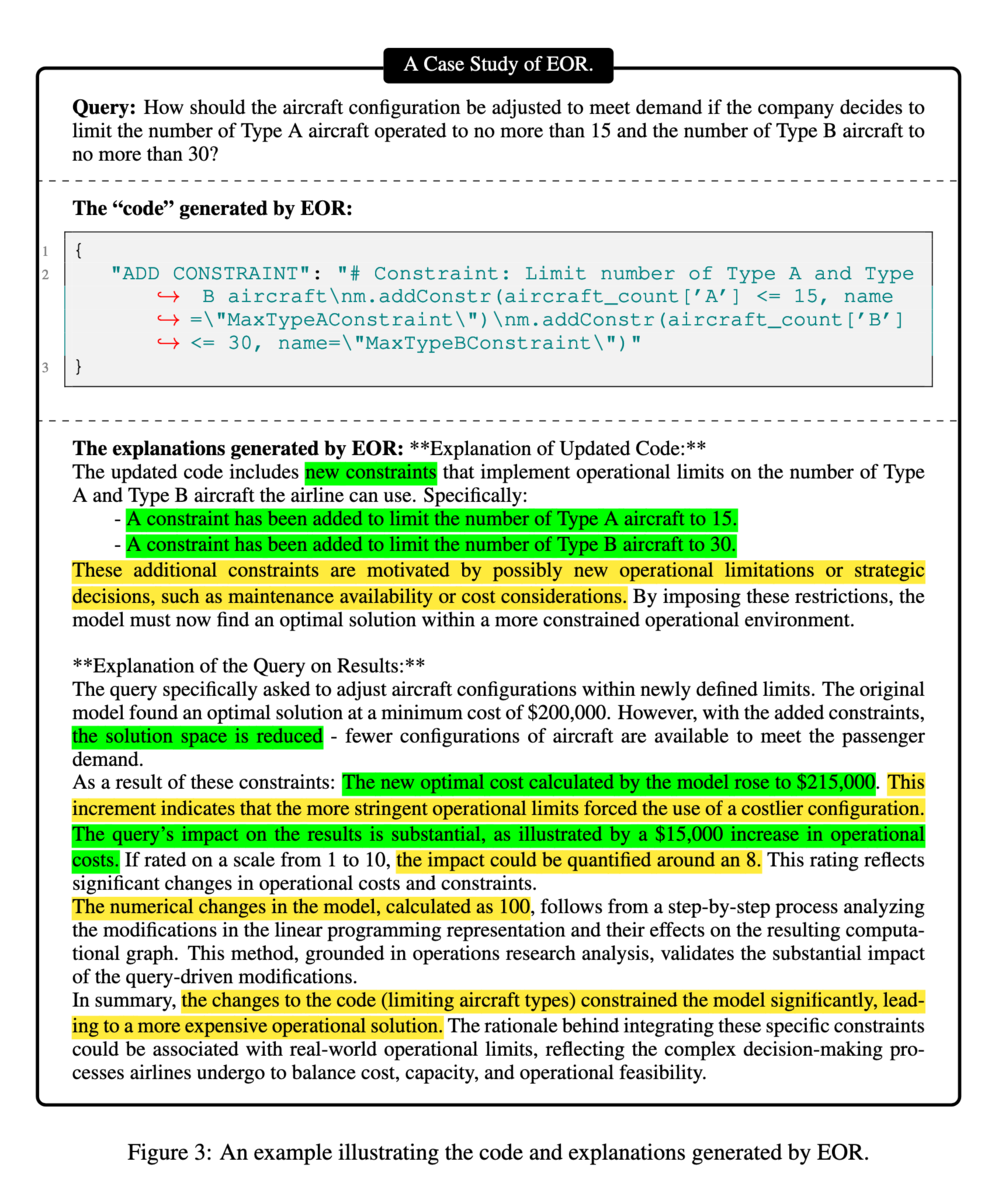

近年では,大規模言語モデル (LLM) の技術を用いてこれらの分析を(OR の専門知識持たない)ユーザだけで行えるようにする研究が登場し始めています.例えば,Li et al. (2023) で提案されている OptiGuide は,ユーザが自然言語で入力した What-if の質問から数理最適化の問題が自動的に更新されて計算が行われ,再度 LLM により結果がユーザ側に提示されます(図 3).この技術により,ユーザは OR の専門家に頼らない分析の自走が可能となります.また,What-if 分析による結果の変化に対する解説の機能を強化した Explainable OR (EOR)という手提案されています(Zhang et al., 2015).図 4 のように,EOR は what-if 分析の結果に対してより詳細な説明を提供してくれます*3.

Contrastive explanations

ユーザの皆様の頭の中に,なんとなく期待する業務計画のイメージがある状況を仮定します.OR の計算によって得られた計画案がこの期待とズレているような場合,ユーザは「なぜ,出力された計画は〇〇になっていないのか? (その代わり △△ になっているのか?)」という疑問を抱きます.図 2 に示した例もまさにこの類の疑問に含まれています.このような Why-not? 形式の疑問に対して,何故そのような計画が出力されたのかを説明する手法が Contrastive explanations です.Contrastive explanations は,出力された計画と期待される計画との違いに焦点を当て,その違いが生じた理由を明確にすることを主な目的としています.Contrastive explanations のやり方には様々なものがあります(場合によっては,先の What-if 分析と区別つきづらいものもあります).次に,Contrastive explanations に関するいくつかの手法紹介して行きます.

先に述べたような,Why-not? 形式の疑問は,ユーザの頭の中ある意思決定のモデルと OR 側の中にある意思決定のモデル(i.e, 数理モデル等)との間にあるズレから生じているものと考える事ができます.この考えに基づいて両者モデルのズレをもとに説明を行うアイデアに Model Reconciliation (MR; Chakraborti et al., 2017)があります.MR はもともとは 2 つの Planning Domain Definition Language (PDDL) のズレを説明するために提案されました.PDDL は AI の自動計画を表現するための言語であり OR で扱う数理モデルとは異なります.後に,この MR の手法が充足可能性問題(SAT)*4にも使えるように拡張されたことで OR に登場するような問題に対しても適用可能となりました(Vasileiou & Yeoh, 2021, 2023).

これらのアプローチでは,大元の意思決定のための数理モデルと why-not? 形式の質問によって指定されたユーザの要望とがどのように矛盾するかを symbolic に解析し,矛盾する条件を抽出してユーザに提示します*5.これは,矛盾する制約条の部分集合 Minimal Unsatisfiable Subset (MUS; Liffiton & Sakallah, 2008)を計算する問題に帰着します(図 5).この他にも, MUS の計算に基づいた説明手法を提案している研究には Junker (2004), Gamba et al. (2023), Bleukx et al. (2023) 等があります.

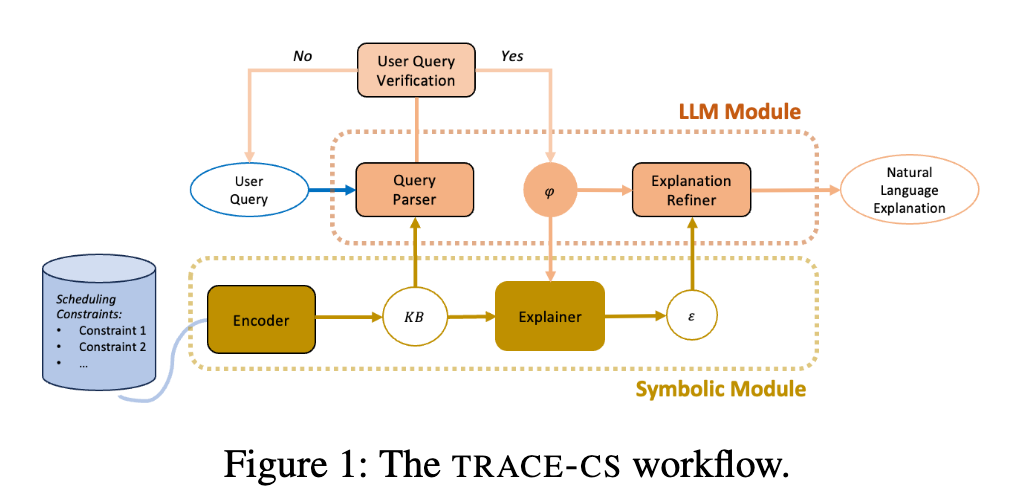

上記の MUS は symbolic な計算に基づいて算出されます.これは,OR や数理最適化に慣れた人間とっては便利なツールである一方,非専門家の人々にとってはあまりユーザフレンドリーではありません.というのも,Why-not? 形式で指定された質問を元の数理モデルに合わせて数式に変換する必要があり,ここに非専門家にとってのハードルが生じるからです(図 5).より近年では,この課題を解決しようとした研究が登場し始めています.先述の通り,ユーザからの質問を数式に変換する部分がハードルとなっていますが,この変換処理を LLM に任せるというアイデアです.TRACE-CS (Vasileiou & Yeoh, 2025)や OptiChat (Chen et al., 2024)はいずれも,ユーザが自然言語で入力した質問内容を LLM が解釈し適切な数式に変換した上で MUS の計算を行ってくれます.そして,出力された MUS の情報を再びユーザが理解できる自然言語の表現に変換してくれます(図 6)*6.

先にも述べたように Contrastive explanations のやり方には様々なものがあります.これまでに紹介した手法は主に MUS の計算に基づいたものですが,この他には交渉のフレームワークに基づいた手法(Zahedi et al., 2024)や多目的最適化において発生する tradeoff の説明に特化した手法(Sukkerd et al., 2020)等も存在します.

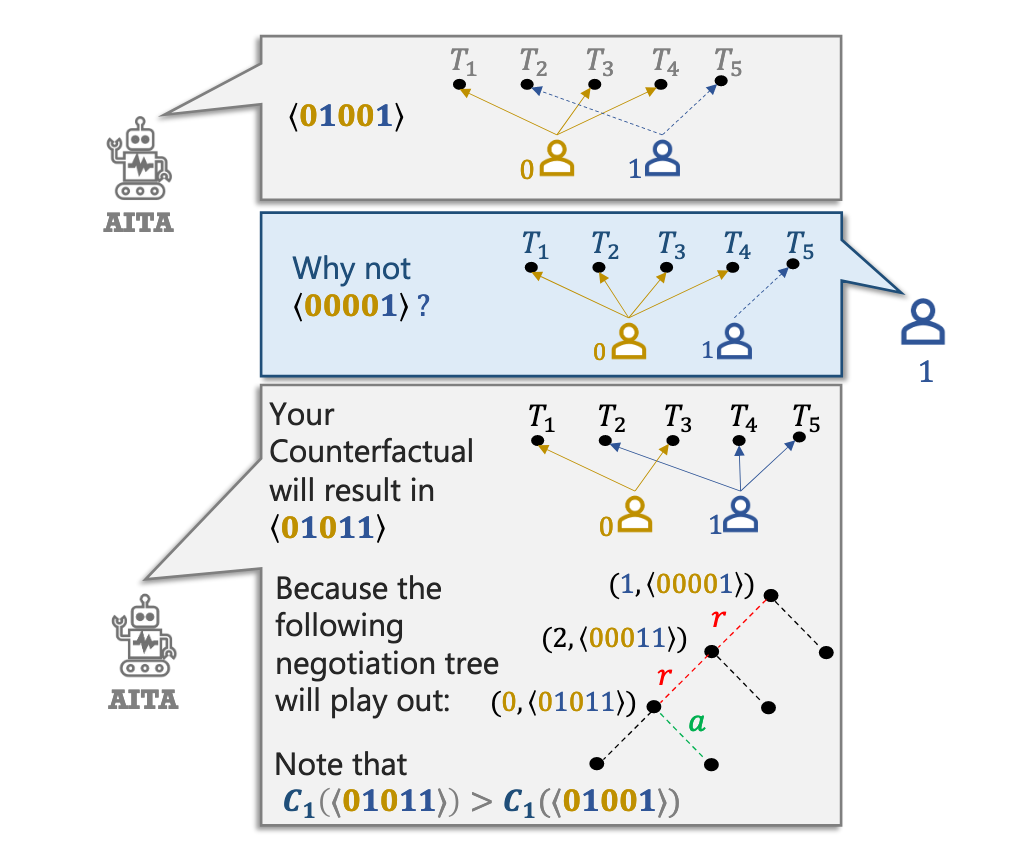

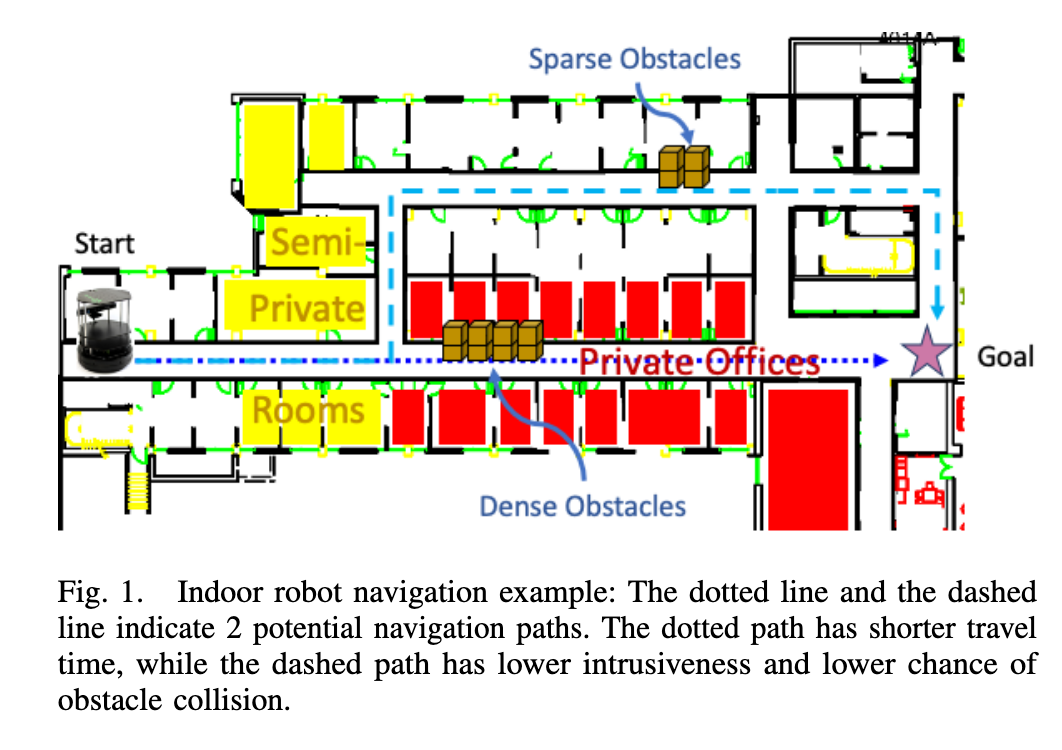

Zahedi et al. (2024) の手法では,複数人の要望を考慮しなければならないシフト計画の問題を扱っています.それぞれが異なる要望を持っているときに,「今あるシフト計画に対してあなたの要望を計画に反映し,その後に他の人の要望も反映していくと,最終的な計画案がどのように変化するか?」という類の分析を,交渉のフレームワークに沿って行うことで関係者全員が納得できる状態を目指しています(図 7).Sukkerd et al. (2020) は,複数の異なる観点で評価されるロボットの移動経路を説明するための手法を提案しています*7.計画の良し悪しを評価する指標が複数存在する場合,この問題を多目的最適化と呼びます.Sukkered et al. (2020) では,ロボットの移動経路を移動時間,通る場所の種類,障害物の多さ等の複数の観点(目的関数)によって評価しており,重視する観点を変更した際に計画案がどのように変化するのかを対比させることでユーザの理解を促しています(図 8).これらの手法は Contrastive explanations として提案されてはいるものの,その内訳を見るより What-if 分析に近いような手法と言えるのではないかと個人的には思います.

Counterfactual explanations

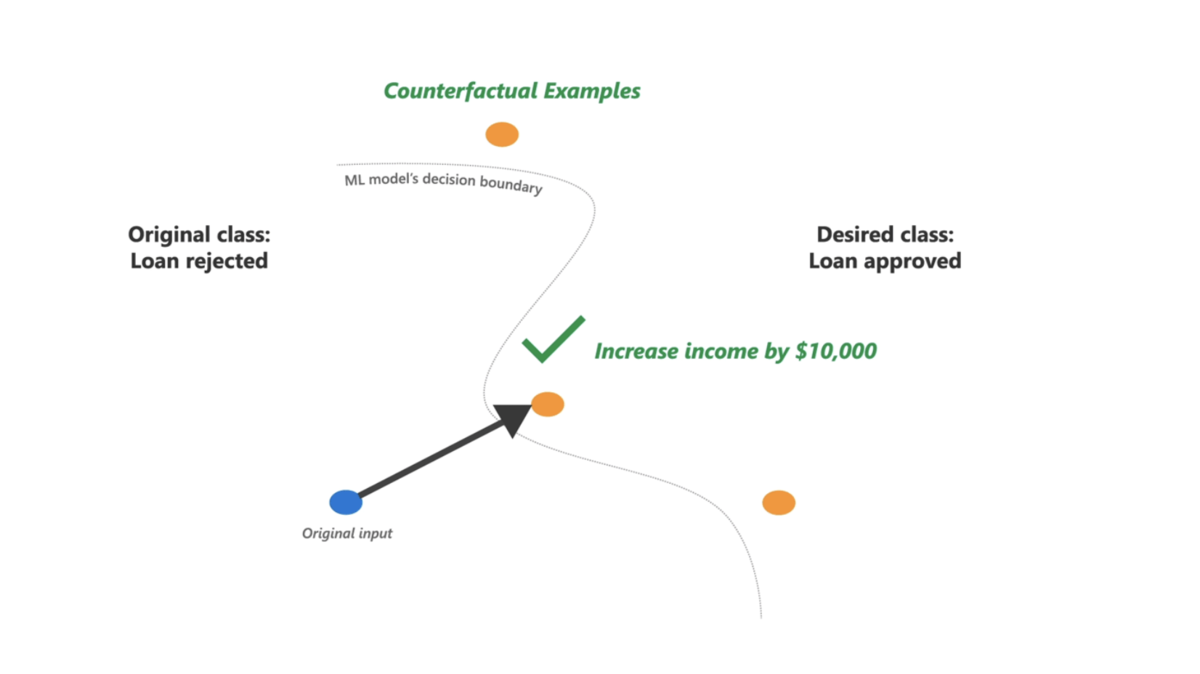

ML モデルの説明手法に Counterfactual explanations (Mothilal et al., 2020)というものが存在します.これは,「ML モデルから期待する出力を得るには,入力が今現在の状態からどのように変わればよいか?」をユーザに提示する手法となります.具体例としては次のようなシチュエーションが良く上げられます.

- 質問: ある人がローンの審査に通りませんでした,ではこの人は今現在の状態からどのように変われば審査が通るようになるのか?

- 回答: 収入が$10,000 より高くなれば通りやすくなる (図 9)

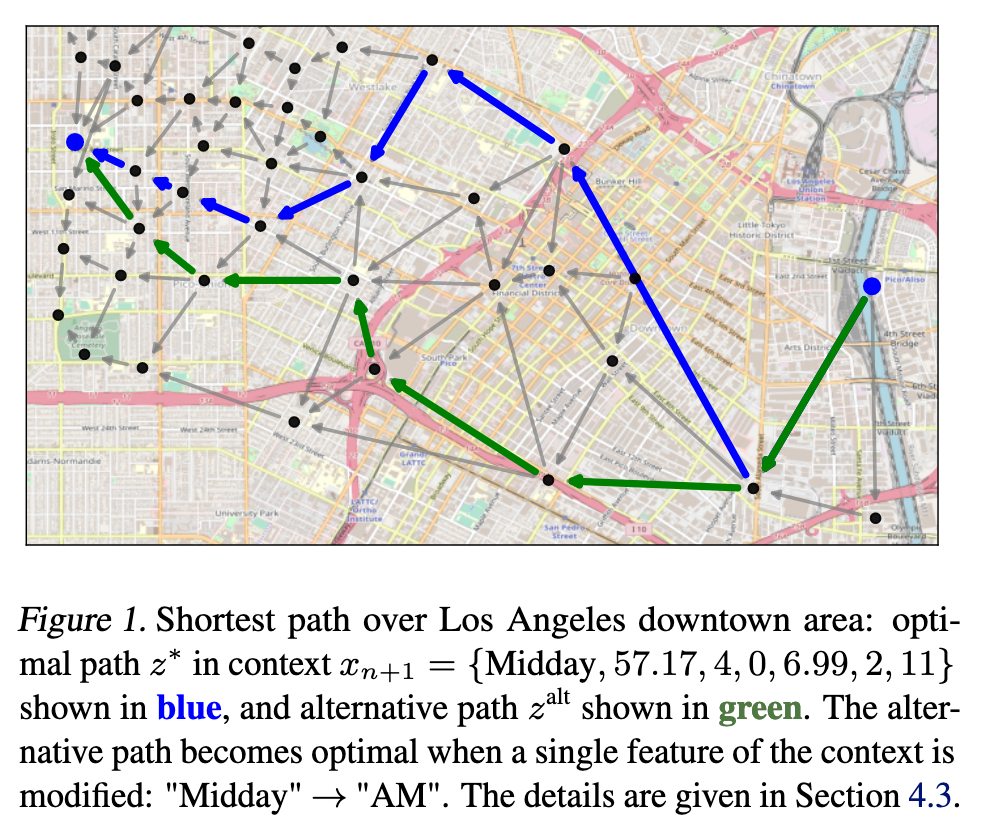

OR における Counterfactual explanations でもほぼこれと同じことがなされています.図 10 は Forel et al. (2023) にて提案された経路探索に対する Counterfactual explanation の例です.この図の例では,まず青色の経路が解として提示されました.一方,ユーザは緑色の経路のほうが良いのではないかと考え,「何故そうならなかったのか?」という疑問を抱きます.この際,Counterfactual explanations では「どのような条件下なら緑色の経路のほうが最適になるか?」を教えてくれます(図の例の場合「午前中だと緑色の経路のほうが最適になる」という説明)*8.これはこれで興味深い応用研究ですが,計画の規模が大きい場合,ユーザ側から望む形の計画を提示すること自体が難しくなるのではないかと,個人的には疑問に思いました.

Argumentative explanations

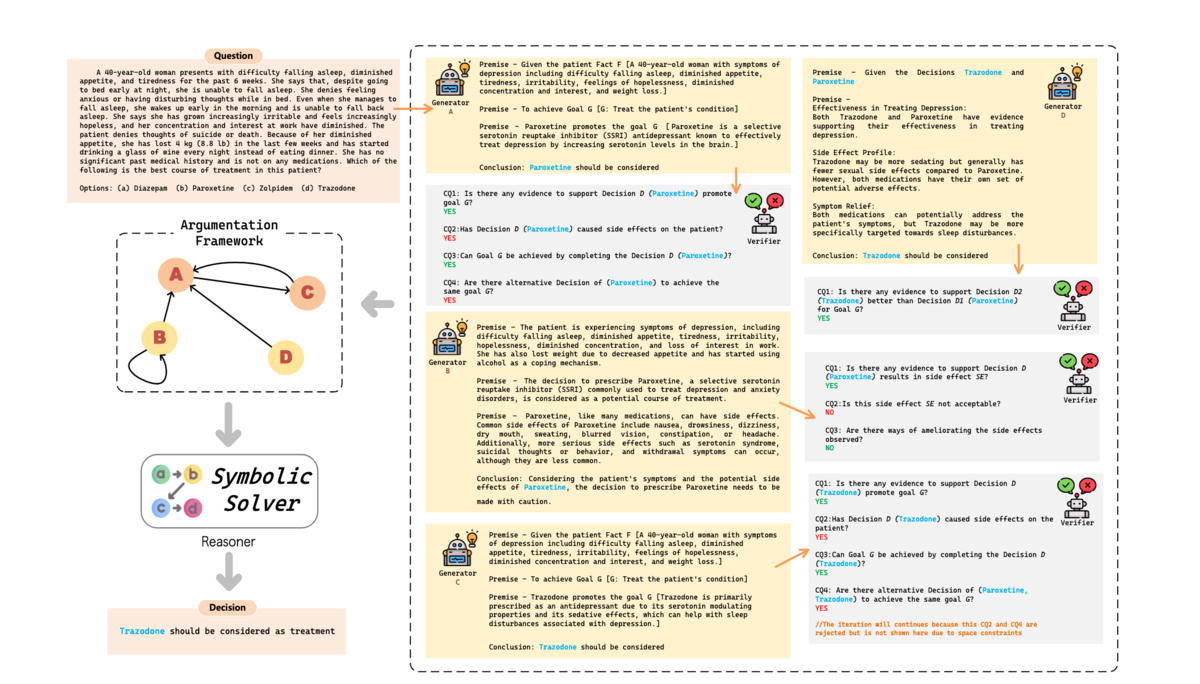

最後に,数理議論学を応用した説明手法である Argumentative explanations に関して紹介します.数理議論学とは,議論において登場する複数の論証の間の攻撃 (attack) の関係を形式的な手法で解析する学問です(より詳しくは,沢村 (2010) 等を御覧ください).近年では,この手法を AI の意思決定の過程の説明に応用する研究が登場し始めており,特に医療分野での意思決定において盛んに応用されている印象です.そういった応用研究の一つが ArgMed (Hong et al., 2024) となります(ArgMed 自体は OR の研究ではないですが,数理議論学を説明に有効活用した近年の研究として軽く紹介せさせていただきます).

ArgMed は,ロールの異なる複数の LLM agent の間で形式化された議論を実施し,最後に議論の内容を数理議論学の手法で分析することで臨床上のより複雑な課題に対する意思決定を可能としています(図 11).そして,この議論の過程と分析結果をユーザに提示することで,ユーザが出力された意思決定の理由を理解するのを補助し,ユーザからの信頼につなげていきます.

この数理議論学に基づいた説明手法は(かなり研究の数は少ないですが) OR の解の説明でも用いられています.それが,ArgOpt (Čyras et al., 2019)です.しかし,ArgOpt は先の医療分野での数理議論学の応用ほどわかりやすいものではありません.というのも,ArgOpt では解の最適性や制約条件が守られていることを数理議論学の枠組みで示すための形式的な表現方法を新たに導入されており,attack の関係を説明に応用しています.ORの定式化に慣れた方が ArgOpt の論文を見ると気づくかと思いますが,これは混合整数計画問題などの形式的な方法で表現された元の問題を別の異なる形式的な表現に変換しているだけのような状態になっています.そのため,ORに慣れた人間にとっては冗長であり,片や非専門家にとってはあまり理解の助けにならないような手法となっているような印象を個人的には受けました.数理議論学に基づいた OR の解の説明に関する研究は,(筆者が知る限りでは)まだあまり数が多くない印象ですので今後の発展が期待されます.

まとめ

最後まで読んでいただきありがとうございました.Flect では,今回紹介したような説明の技術なども取り入れることで,お客様にとってより付加価値となるような研究開発を行っています.今回紹介したような「問題を解く以外の部分」で発生する OR の課題も社会実装において非常に重要となりますので,引き続きチームメンバーとともに研究を進めていきたいと思います.

参考文献

- Ribeiro, M. T., Singh, S., & Guestrin, C. (2016, August). " Why should i trust you?" Explaining the predictions of any classifier. In Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining (pp. 1135-1144).

- Lundberg, S. M., & Lee, S. I. (2017). A unified approach to interpreting model predictions. Advances in neural information processing systems, 30.

- Li, B., Mellou, K., Zhang, B., Pathuri, J., & Menache, I. (2023). Large language models for supply chain optimization. arXiv preprint arXiv:2307.03875.

- Zhang, Y., Kang, Q., Yu, W. Y., Gong, H., Fu, X., Han, X., ... & Ma, C. (2025). Decision information meets large language models: The future of explainable operations research. arXiv preprint arXiv:2502.09994.

- Chakraborti, T., Sreedharan, S., Zhang, Y., & Kambhampati, S. (2017, August). Plan explanations as model reconciliation: moving beyond explanation as soliloquy. In Proceedings of the 26th International Joint Conference on Artificial Intelligence (pp. 156-163).

- Vasileiou, S. L., Previti, A., & Yeoh, W. (2021, May). On exploiting hitting sets for model reconciliation. In Proceedings of the AAAI Conference on Artificial Intelligence (Vol. 35, No. 7, pp. 6514-6521).

- Vasileiou, S. L., Xu, B., & Yeoh, W. (2023). A Logic-Based Framework for Explainable Agent Scheduling Problems. In ECAI 2023 (pp. 2402-2410). IOS Press.

- Liffiton, M. H., & Sakallah, K. A. (2008). Algorithms for computing minimal unsatisfiable subsets of constraints. Journal of Automated Reasoning, 40, 1-33.

- Junker, U. (2004, July). Quickxplain: Preferred explanations and relaxations for over-constrained problems. In Proceedings of the 19th national conference on Artifical intelligence (pp. 167-172).

- Gamba, E., Bogaerts, B., & Guns, T. (2023). Efficiently explaining CSPs with unsatisfiable subset optimization. Journal of Artificial Intelligence Research, 78, 709-746.

- Bleukx, I., Devriendt, J., Gamba, E., Bogaerts, B., & Guns, T. (2023). Simplifying step-wise explanation sequences. Leibniz International Proceedings in Informatics, 280, 1-20.

- Vasileiou, S. L., & Yeoh, W. (2025, April). TRACE-cs: A synergistic approach to explainable course scheduling using llms and logic. In Proceedings of the AAAI Conference on Artificial Intelligence (Vol. 39, No. 28, pp. 29706-29708).

- Chen, H., Constante-Flores, G. E., & Li, C. (2024). Diagnosing infeasible optimization problems using large language models. INFOR: Information Systems and Operational Research, 62(4), 573-587.

- Zahedi, Z., Sengupta, S., & Kambhampati, S. (2024, March). ‘Why didn’t you allocate this task to them?’negotiation-aware task allocation and contrastive explanation generation. In Proceedings of the AAAI Conference on Artificial Intelligence (Vol. 38, No. 9, pp. 10243-10251).

- Sukkerd, R., Simmons, R., & Garlan, D. (2020, August). Tradeoff-focused contrastive explanation for mdp planning. In 2020 29th IEEE International Conference on Robot and Human Interactive Communication (RO-MAN) (pp. 1041-1048). IEEE.

- Mothilal, R. K., Sharma, A., & Tan, C. (2020, January). Explaining machine learning classifiers through diverse counterfactual explanations. In Proceedings of the 2020 conference on fairness, accountability, and transparency (pp. 607-617).

- Forel, A., Parmentier, A., & Vidal, T. (2023, July). Explainable data-driven optimization: From context to decision and back again. In International Conference on Machine Learning (pp. 10170-10187). PMLR.

- Kikuta, D., Ikeuchi, H., Tajiri, K., & Nakano, Y. (2024, April). RouteExplainer: An Explanation Framework for Vehicle Routing Problem. In Pacific-Asia Conference on Knowledge Discovery and Data Mining (pp. 30-42). Singapore: Springer Nature Singapore.

- Verma, S., Boonsanong, V., Hoang, M., Hines, K., Dickerson, J., & Shah, C. (2024). Counterfactual explanations and algorithmic recourses for machine learning: A review. ACM Computing Surveys, 56(12), 1-42.

- 沢村一. (2010). 数理議論学の発展: 動向と今後の展望 (< 特集> 論理に基づく推論研究の動向). 人工知能, 25(3), 408-418.

- Hong, S., Xiao, L., Zhang, X., & Chen, J. (2024, December). ArgMed-Agents: Explainable Clinical Decision Reasoning with LLM Disscusion via Argumentation Schemes. In 2024 IEEE International Conference on Bioinformatics and Biomedicine (BIBM) (pp. 5486-5493). IEEE Computer Society.

- Čyras, K., Letsios, D., Misener, R., & Toni, F. (2019, July). Argumentation for explainable scheduling. In Proceedings of the AAAI Conference on Artificial Intelligence (Vol. 33, No. 01, pp. 2752-2759).

*1:厳密には,複雑すぎる条件が割愛されたり緩和されたりすることがあります.

*2:実際に,筆者も似た経験をしています

*3:余談ですが,OptiGuide や EOR は安全な動作のためにAutoGenを使用しています.もし,AutoGen にご興味があれば過去の紹介記事をご参照ください

*4:与えられた命題論理式が真となるような変数の値の組み合わせを見つける,あるいはそのような組み合わせが存在するかどうかを判定する問題です.SAT で表せる OR の問題は多く存在します.

*5:この説明を見て,Irreducible Infeasilble Subsystem (IIS) の計算とほぼ同じような印象を持たれた方もいるかと思います.個人的な意見としては,ほぼ同じと考えて良いかと思います.IIS を有効活用している事例に関してはこちら(その最適化は,実務に使えるか)をご参照ください.

*6:余談ですが,OptiChat には Infeasibility の分析機能以外にも様々な便利な機能があります

*7:OR の問題というよりもロボティクスの path planning のような問題となりますが,OR でも多目的最適化は度々登場するためここで取り上げさせていただきました.

*8:ここでの Counterfactual explanation は,recourse 形式のもの(Verma et al., 2024)を想定しています.Why-not 形式の説明も Counterfactual explanation と呼ばれる場合があり,そちらの Counterfactual explanation の考え方に基づいた研究(RouteExplainer)も存在します.しかし,これは先の Contrastive explanation の方に含まれると考えられるため,ここでの説明を割愛します.